以Python為例,手把手教你Spark應(yīng)用開(kāi)發(fā)的軟件設(shè)計(jì)與實(shí)踐

Apache Spark作為當(dāng)今大數(shù)據(jù)領(lǐng)域最主流的計(jì)算框架之一,憑借其卓越的內(nèi)存計(jì)算性能、豐富的API和高度的可擴(kuò)展性,已成為企業(yè)級(jí)數(shù)據(jù)處理的基石。本文將以Python(PySpark)為例,系統(tǒng)地介紹Spark應(yīng)用開(kāi)發(fā)的軟件設(shè)計(jì)理念與核心開(kāi)發(fā)實(shí)踐,旨在幫助開(kāi)發(fā)者構(gòu)建高效、健壯且易于維護(hù)的Spark應(yīng)用程序。

第一部分:理解Spark核心架構(gòu)與PySpark生態(tài)

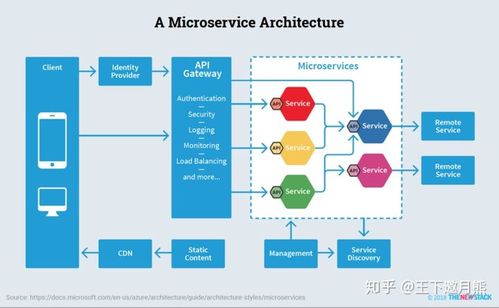

Spark應(yīng)用開(kāi)發(fā)的第一步是理解其核心架構(gòu)。Spark采用主從(Master-Slave)架構(gòu),核心組件包括:

- Driver Program:即用戶編寫(xiě)的Spark應(yīng)用主程序(如我們的Python腳本),負(fù)責(zé)創(chuàng)建SparkContext,定義數(shù)據(jù)轉(zhuǎn)換操作,并向集群管理器提交任務(wù)。

- Cluster Manager:負(fù)責(zé)資源的統(tǒng)一管理和調(diào)度,如Standalone、YARN或Kubernetes。

- Executor:運(yùn)行在工作節(jié)點(diǎn)(Worker Node)上的進(jìn)程,負(fù)責(zé)執(zhí)行Driver分配的具體計(jì)算任務(wù),并存儲(chǔ)數(shù)據(jù)。

PySpark是Spark為Python開(kāi)發(fā)者提供的API,它通過(guò)Py4J庫(kù)在Python解釋器和JVM Executor之間建立橋梁,使得我們可以用簡(jiǎn)潔的Python語(yǔ)法調(diào)用強(qiáng)大的Spark引擎。

第二部分:Spark應(yīng)用開(kāi)發(fā)的軟件設(shè)計(jì)原則

開(kāi)發(fā)一個(gè)生產(chǎn)級(jí)別的Spark應(yīng)用,遠(yuǎn)不止于編寫(xiě)幾行轉(zhuǎn)換代碼。良好的軟件設(shè)計(jì)至關(guān)重要。

1. 模塊化與可復(fù)用性

將業(yè)務(wù)邏輯分解為獨(dú)立的、功能單一的模塊。例如,可以將數(shù)據(jù)讀取、數(shù)據(jù)清洗、特征工程、模型訓(xùn)練等步驟封裝成不同的函數(shù)或類。這不僅使代碼清晰,也便于單元測(cè)試和復(fù)用。

`python

# 示例:數(shù)據(jù)讀取模塊

def load_data(spark, path, format="parquet"):

return spark.read.format(format).load(path)

示例:數(shù)據(jù)清洗模塊

def clean_data(df):

return df.dropDuplicates().fillna(0)

`

2. 配置化管理

避免將硬編碼(如文件路徑、數(shù)據(jù)庫(kù)連接參數(shù)、并行度等)散落在代碼各處。應(yīng)使用配置文件(如JSON、YAML)或環(huán)境變量來(lái)管理這些參數(shù),使應(yīng)用更靈活,便于在不同環(huán)境(開(kāi)發(fā)、測(cè)試、生產(chǎn))間遷移。

3. 錯(cuò)誤處理與健壯性

對(duì)潛在的錯(cuò)誤(如數(shù)據(jù)缺失、連接失敗)進(jìn)行預(yù)判和處理。使用try-except塊,并記錄詳細(xì)的日志,方便問(wèn)題追蹤。Spark應(yīng)用本身也應(yīng)配置合理的重試機(jī)制。

4. 性能考量設(shè)計(jì)

在設(shè)計(jì)階段就需思考性能:

- 分區(qū)策略:根據(jù)數(shù)據(jù)量和操作類型,合理設(shè)置RDD/DataFrame的分區(qū)數(shù)(

repartition/coalesce),避免數(shù)據(jù)傾斜。

- 持久化策略:對(duì)于會(huì)被多次使用的中間結(jié)果,明智地使用

cache()或persist(),但要注意內(nèi)存開(kāi)銷。

- 廣播變量與累加器:對(duì)于只讀的查找表,使用廣播變量(

broadcast)能極大提高Join效率;使用累加器(accumulator)進(jìn)行安全的狀態(tài)聚合。

第三部分:PySpark應(yīng)用開(kāi)發(fā)實(shí)戰(zhàn)流程

步驟1:環(huán)境搭建與初始化

`python

from pyspark.sql import SparkSession

創(chuàng)建SparkSession,這是所有Spark功能的統(tǒng)一入口

spark = SparkSession.builder \

.appName("MyFirstPySparkApp") \

.config("spark.executor.memory", "4g") \

.getOrCreate()

`

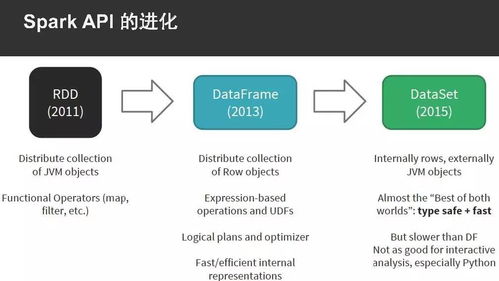

步驟2:數(shù)據(jù)抽象與操作

Spark的核心抽象是彈性分布式數(shù)據(jù)集(RDD)和更高級(jí)的DataFrame/Dataset。DataFrame API因其優(yōu)化器和Tungsten執(zhí)行引擎,是首選。

`python

# 讀取數(shù)據(jù),創(chuàng)建DataFrame

df = spark.read.csv("hdfs://path/to/data.csv", header=True, inferSchema=True)

使用DataFrame API進(jìn)行轉(zhuǎn)換操作(懶執(zhí)行)

from pyspark.sql import functions as F

resultdf = df.filter(df["age"] > 18) \

.groupBy("department") \

.agg(F.avg("salary").alias("avgsalary"))

`

步驟3:應(yīng)用提交與執(zhí)行

開(kāi)發(fā)完成后,使用spark-submit命令將應(yīng)用提交到集群運(yùn)行。

`bash

spark-submit \

--master yarn \

--deploy-mode cluster \

--executor-memory 2G \

mysparkapp.py

`

第四部分:測(cè)試與調(diào)試

- 單元測(cè)試:使用

pytest等框架,結(jié)合pyspark-testing等庫(kù),對(duì)數(shù)據(jù)轉(zhuǎn)換函數(shù)進(jìn)行本地小規(guī)模測(cè)試。 - 本地調(diào)試:在IDE中設(shè)置

master為local[*]進(jìn)行本地運(yùn)行和斷點(diǎn)調(diào)試。 - 日志分析:充分利用Spark Web UI(4040端口)和Executor日志,分析任務(wù)執(zhí)行時(shí)間、數(shù)據(jù)傾斜和GC情況。

第五部分:進(jìn)階設(shè)計(jì)模式

- Lambda架構(gòu):結(jié)合Spark Streaming(或Structured Streaming)處理實(shí)時(shí)數(shù)據(jù)流,與批處理層結(jié)果合并,提供全量+增量的數(shù)據(jù)視圖。

- Medallion架構(gòu):在數(shù)據(jù)湖中組織數(shù)據(jù)為青銅層(原始數(shù)據(jù))、白銀層(清洗后)、黃金層(業(yè)務(wù)聚合),Spark是各層間轉(zhuǎn)換的理想工具。

###

以Python進(jìn)行Spark應(yīng)用開(kāi)發(fā),關(guān)鍵在于將Python的靈活性與Spark的分布式計(jì)算能力相結(jié)合,并輔以嚴(yán)謹(jǐn)?shù)能浖こ淘O(shè)計(jì)思想。從理解架構(gòu)出發(fā),遵循模塊化、可配置的設(shè)計(jì)原則,熟練運(yùn)用DataFrame API,并時(shí)刻關(guān)注性能與健壯性,你就能設(shè)計(jì)并開(kāi)發(fā)出高效、可靠的大數(shù)據(jù)應(yīng)用,從容應(yīng)對(duì)海量數(shù)據(jù)的挑戰(zhàn)。

如若轉(zhuǎn)載,請(qǐng)注明出處:http://www.careintegrator.cn/product/59.html

更新時(shí)間:2026-01-11 00:22:57